Google e la Multisearch con l’intelligenza artificiale.

Da aprile di quest’anno è possibile inquadrare un oggetto qualsiasi con il proprio smartphone e attraverso l’utilizzo di Google Lens scattare una foto e inserire un testo con la query di ricerca.

Ad esempio, si può fotografare una pianta ed editare il testo “curare pianta malata” per avere nei risultati video e pagine web la risposta a ciò che si sta cercando.

Vai qui per andare sull’articolo di Google

Con la ricerca multipla, puoi fare una domanda su un oggetto di fronte a te o perfezionare la tua ricerca per colore, marca o un attributo visivo.

Se vuoi provare ad usare Lens con questa nuova funzionalità:

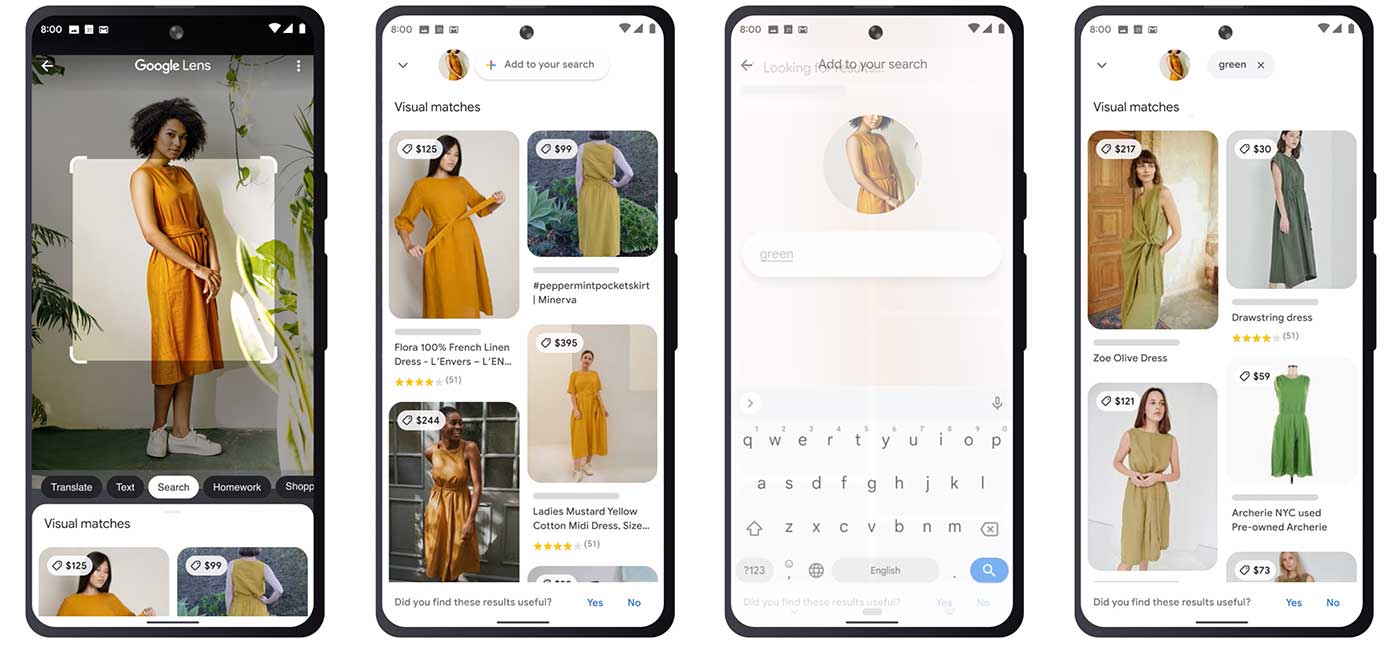

– fai uno screenshot di un vestito e aggiungi la domanda “verde” per trovarlo in un altro colore

– scatta una foto del tuo tavolo da pranzo e aggiungi la domanda “tavolino da caffè” per trovare un tavolo corrispondente

– scatta una foto della tua pianta di rosmarino e aggiungi la query “istruzioni per la cura”

La ricerca multipla è possibile grazie a MUM (Multitask Unified Model), la nuova AI di Google che è in grado di capire le domande e di mettere in relazione dati differenti, per poi poter offrire agli utenti risorse utili e contestualizzate in tempo reale.

Quindi, combinando in un’unica richiesta i testi e le immagini, si semplifica la ricerca visiva che diventa più naturale ed intuitiva e di conseguenza si migliora l’esperienza utente.